フィードバック + コントロール

ユーザーがAIプロダクトにフィードバックをすると、AIのパフォーマンスとユーザーエクスペリエンスを、時間とともに大きく向上させることができます。この章の内容は次のとおりです。

- AIはどのようにユーザーのフィードバックを求め、それに応えればよいでしょうか?

- 暗黙的および明示的なユーザーフィードバックをともに、AIが解釈して使えるようにするにはどうすればよいですか?

- ユーザーに与えるコントロールとカスタマイズの適切なレベルは何ですか?

議論を円滑にし、イテレーションをスピードアップし、落とし穴を避けたいですか? ワークシートを使用してください。

AIを使うときに新しいこと

ユーザーのフィードバックは、ユーザーと、プロダクト、そしてチームのあいだのコミュニケーションチャネルです。フィードバックを活用することは、テクノロジーを向上させ、コンテンツをパーソナライズし、ユーザーエクスペリエンスを向上させる、強力でスケーラブルな方法です。

AIプロダクトにおいて、基盤となるAIモデルの出力とユーザーエクスペリエンスを向上させるのに、ユーザーのフィードバックとコントロールがとても重要です。ユーザーがフィードバックをできるようになれば、ユーザーは自分のエクスペリエンスをパーソナライズし、プロダクトがユーザーにもたらす利益を最大化することに対して、直接の役割を果たすことができます。ユーザーがシステムに対して適切なレベルのコントロールを持っていれば、システムへの信頼感が高くなります。

フィードバックとコントロールメカニズムについてに主に考えるべき点は次です。

➀ フィードバックをモデルの改善に合わせる。暗黙的なフィードバックと明示的なフィードバックの違いを明らかにし、適切な粒度で有用な質問をします。

➁ 影響を与える価値と時期を伝える。人々がなぜフィードバックをするのか理解し、ユーザーエクスペリエンスがいつどのように向上されるのか、期待値を設定します。

➂ コントロールと自動化のバランスをとる。ユーザーに、エクスペリエンスの特定の側面においてコントロールを与え、フィードバックをすることをかんたんにオプトアウトできるようにします。

➀ フィードバックをモデルの改善に合わせる。

一般に、フィードバックを収集するためのメカニズムには「暗黙的」なものと「明示的」なものがあります。どちらのタイプのフィードバックでも、どのような情報を収集しているのか、それが何のためにあるのか、それがユーザーにどのように利益になるのかを、ユーザーに知らせることが重要です。できるかぎり、フィードバックを使ってAIを向上させる方法を見つけてください。

暗黙的なフィードバックを確認する

暗黙的なフィードバックは、プロダクトログからわかるユーザーの行動やインタラクションに関するデータです。このフィードバックには、ユーザーがアプリを開いた日時や、レコメンドを受け入れた、または拒否した回数など、貴重なかたまりが含まれることがあります。これらの情報はたいていは、ふだんのプロダクトの利用の一環として発生します。この種の情報を明示的に要求する必要はありませんが、収集していることをユーザーに通知し、許諾を得てください。

プライバシーについては、「メンタルモデル」と「データ収集 + 評価」で少し話しました。ユーザーは、自分の行動がいつ入力やフィードバックとして使われているのかをつねに意識しているわけではないので、このデータの用途を説明するときは、「説明 + 信頼感」と「メンタルモデル」の章にある考慮事項を確認してください。とくに、暗黙的なフィードバックを利用するということ(ユーザーの行動ログをとるなど)を、ユーザーがオプトアウトできるようにすべきです。また、これを利用規約に含める必要があります。

明示的なフィードバックを集める

明示的なフィードバックは、ユーザーが、AIからの出力に対して意図的にコメントをすることです。往々にして、これは定性的です。たとえば、レコメンドが役立つかどうか、写真のラベルなどの分類が間違っていなかったか、あるいはどのくらい間違っていたかなどです。明示的なフィードバックには、アンケート、レーティング、いいねを表す上向きの親指マークや不満を表す下向きの親指マーク、自由入力欄など、さまざまな形式があります。

明示的なフィードバックでする質問と回答は、ユーザーにとって理解しやすいものでなければなりません。また、言葉づかいが望むフィードバックの種類に合った声と調子になっていること、そして攻撃的に受け取れる言葉や表現を避けることも、重要です。深刻なことを尋ねるときに、冗談は一般的には適切ではありません。

明示的なフィードバックにはふたつの方法があります。

- あなたやチームは、テーマについてのユーザーのフィードバックをレビューし、それに応じてプロダクトに変更を加えます。

- データとして、AIモデルに直接にフィードバックします。

後者のためにしているときは、受け取ったフィードバックデータが実際にモデルの改善に使えるようにしてください。システムとユーザーの両方が、フィードバックが何を意味するのかを理解する必要があります。

ほとんどの場合、フィードバックの回答の選択肢は、互いに排他的で、全体に網羅的であるべきです。たとえば、親指を立てるサインと親指を下向きにするサインは明白("いいね" or "いや")で、相互に排他的であり(not "いいね and いや")、有用な意見を網羅しています("ふつう"はあまり実用的ではありません)。より詳細なフィードバックがほしいときは、ユーザーが自分の体験を評価する方法に合った選択肢を示してください。

二重のフィードバックを解釈する

ひとつのフィードバックに、暗黙的なシグナルと明示的なシグナルの両方が同時に含まれることがあります。たとえば、一般的な「いいね」は、他の人とコミュニケーションをとるための手段(明示的なシグナル)であると同時に、レコメンドモデルを調整するために役に立つデータ(暗黙的なシグナル)でもあります。このようなフィードバックは、ユーザーがすることと、ユーザーがAIモデルに望むことのあいだに、明確な関連性がつねにあるとは限らないため、混乱を招く可能性があります。たとえば、あるユーザーがひとつのコンテンツに反応したからといって、その同じコンテンツをもっと見たいという意味だとは限りません。ユーザーはそれを却下しようとしているのかもしれませんし、一時的な好奇心に惹かれただけかもしれません。

このようなとき、モデルのチューニングに暗黙的なシグナルをどのように使うかを検討することが重要です。すべての行動が同じように解釈できるわけではありません。同じように、明示的なフィードバックが広い意味で解釈できるときは、「これは問題ありません」を「これはかつてなく最高のものであり、これから私が見たいのはこのようなものだけです」と言いかえてみて、モデルのチューニングに与える影響を減らすことを検討してください。

モデルのチューニングのための設計

理想は、人々がフィードバックしたいことと、モデルをチューニングするのに役立つデータとが一致することです。しかし、その保証はありません。ユーザー調査をして、人々が影響を与えることができると期待しているものが何かを見つけてください。たとえば、ビデオのレコメンドシステムでは、人々は、AIモデルが理解するのと異なる概念レベルでフィードバックをしたいと思っているかもしれません。モデルは「この制作者のビデオをもっと見たい」と解釈していても、ユーザーは「ペアレントフッドについてのビデオをもっと見たい」と考えているのかもしれません。

さまざまな種類のフィードバックを収集するかしないか、というトレードオフすべてについて、部門横断的にステークホルダーと話し合ってください。強く明確なシグナルはチューニングには最適ですが、行動にもとづいて意図を推測する方法には注意してください。時には、長期間にわたってインタラクションを見ると、行動と意図のより正確なパターンを抽出することができます。

キーコンセプト

プロダクトのAIを改善するためのデータを生む出来事と、それに対応したフィードバックの機会を、できるだけ多くリストアップしてください。広く網を張りましょう。App Storeのレビュー、Twitter、電子メール、コールセンター、プッシュ通知などです。その後、プロダクトのユーザーエクスペリエンスについて、ユーザーやデータが何を語っているのかを、体系的に確認します。

- どのようなユーザーエクスペリエンスが、このフィードバックの機会になりますか?

- ユーザーはどのようなコンテンツにフィードバックをしていますか?

- このフィードバックは暗黙的なものでしょうか、明示的なものでしょうか?

この項の考え方で、ワークシートの演習1をやってみましょう。

➁ 影響を与える価値と時間を伝える

人々にフィードバックをする時間をとってもらうためには、それに価値があり影響力がある必要があります。これをどのように伝えるかが、ユーザーが参加してくれるかどうかの鍵になります。往々にして「価値」は動機づけになるので、具体的なユーザーのメリットの観点からフィードバックのリクエストを組み立ててください。

フィードバックのメリットをユーザーに伝えるためのメッセージ発信を考える前に、そもそも人々がフィードバックをなぜするのか、からはじめましょう。

なぜ人々がフィードバックをするのか理解する

人々が、プロダクトや体験についてフィードバックをする理由は多くあります。以下に、標準的な理由のいくつかを、それぞれの長所と短所とともに挙げます。

物理的な報酬

現金報酬は非常に動機づけになります。Mechanical Turk は、大規模のフィードバックに対する報酬の例です。

長所

- フィードバックを増やす直接的な解決策です。

- フィードバックの量を増やす可能性があります。

短所

- 時間の経過とともに費用がかかります。

- 内発的な動機を損ねる可能性があります。

- ユーザーが部分集合化する傾向があります。

- フィードバックの品質が低下する可能性があります。

象徴的な報酬

これには、仮想バッジなどの身分証、コミュニティへの自己イメージの投影による社会的証明やグループ証、および専門家としての評判などの社会資本、といったものが含まれます。

長所

- コストが低いか無料。

短所

- ユーザーが周りにどのように見られたいかに依存しています。

- コミュニティ内に権力の不均衡を生み出します。

- 内発的な動機を阻害する可能性があります。

個人的な実用性

これには、ユーザーが自分の進捗状況を追いかけたり、あとで何かをブックマークしたり、レコメンドエンジンのようなパーソナライズされたAIモデルを、より関連性の高い出力を得るために明示的にトレーニングしたりすることのような、「自己の定量化」のエクスペリエンスが含まれます。

長所

- ネットワーク効果(たくさんのユーザーの保有)も、コミュニティも、はじめるのに必要ありません。

短所

- プライバシーはコミュニティでの開発に向きません。

- 内発的な動機を阻害する可能性があります。

利他主義

利他的な動機には、プロダクトのレビューを残すことのように、コミュニティをつくり他の人たちが議論できるようにすることや、特定のプロダクトのレビューに異議を唱えることのように、公平性を高めることなどがあります。

長所

- 手助けをしたいという思いにもとづく、率直なフィードバックの可能性。

短所

- 社会的良心のバイアスは、行き過ぎた内容のフィードバックにつながる可能性があります。

- 意見がすでに表明されているときは寄与が減ります。

- 利他主義の度合いは、文化やグループによって異なります。

本質的な動機

本質的な動機は、人々が自分自身を表現するという行為から得られる内面の充足感です。これには、フィードバックをすることによる直接的な楽しみ、意見を表明し表現する能力、コミュニティに参加する楽しみが含まれます。

長所

- ネットワーク効果(たくさんのユーザーの保有)も、コミュニティも、はじめるのに必要ありません。

- 人々は自分が楽しめることをするのが好きです。

短所

- 社会的良心のバイアスは、行き過ぎた内容のフィードバックにつながる可能性があります。

ユーザーにとって知覚される価値と実際の価値を合わせる

メリットが明確でも具体的でもなければ、ユーザーはなぜフィードバックをしなければならないのかを理解できないでしょう。ユーザーはフィードバックするのを避けるかもしれませんし、避けることができないなら、無意味な反応や、プロダクトやコミュニティにとって結局は有害になるフィードバックをするかもしれません。

ユーザーが、自分のフィードバックがプロダクトの開発者にしか価値がないと思ったら、意図的に悪いフィードバックをするかもしれません。たとえば、あなたの「無料」アプリの背後にある意図が、じつはユーザーに無許可で集めたデータを広告主に売ることだとユーザーが推測したら、アンケートで得られるフィードバックは色づけされているでしょう。

理想的には、ユーザーは自分のフィードバックの価値を理解し、それがわかる形でプロダクトに現れることです。ユーザーにとって、AIが何を実際に提供してくれるのか、わかることを価値へと結びつけるのは、あなた次第です。

ユーザーエクスペリエンスの変化にフィードバックを結びつける

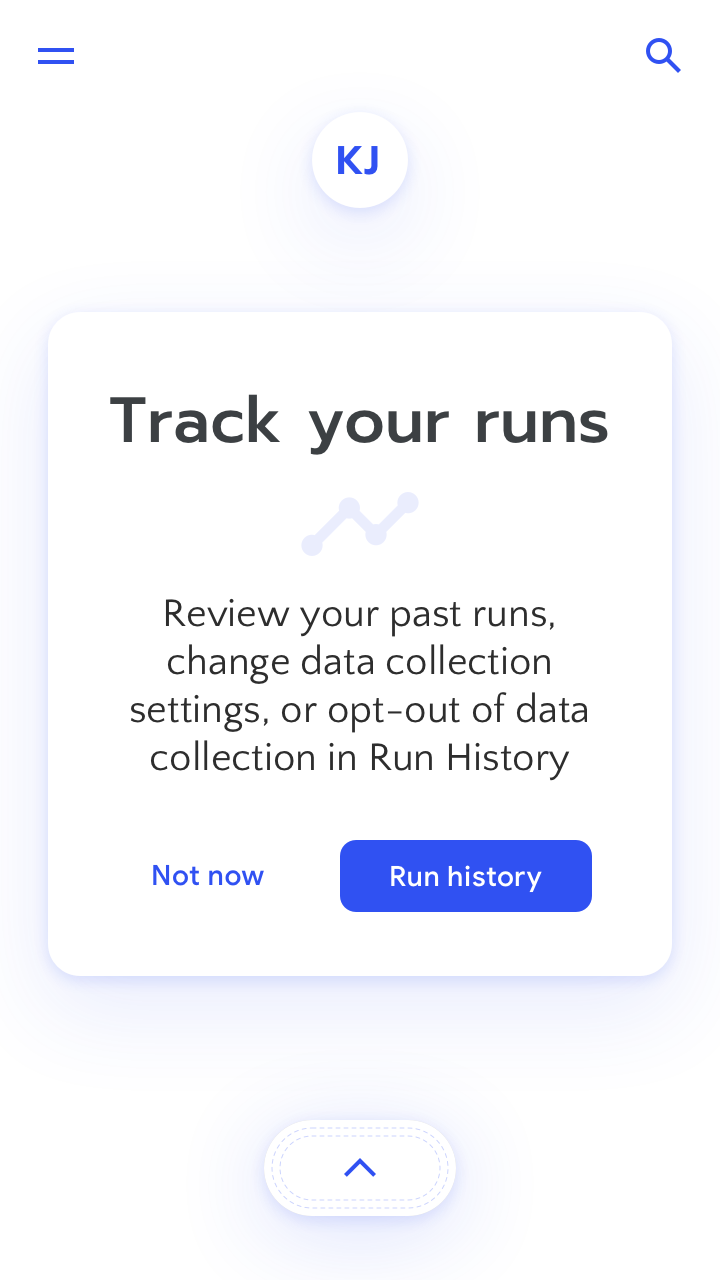

ユーザーからのフィードバックを受け取ったことを感謝するだけでも信頼感をつくることができますが、しかしできれば、プロダクトは、システムが次に何をするのか、あるいはユーザーの入力がAIにどのような影響を与えるのか、知らせるとよいでしょう。

ユーザーのフィードバックが、いつどのようにユーザー個々の体験を変えるのか、具体的に伝えることが必ずしもできるとは限りません。しかしできるなら、プロダクトが決まったスケジュールで体験を届けることができるようにしてください。できることなら、ユーザーへすぐに影響のあるフィードバックをしてください。

以下に、フィードバックのタイミングと影響を説明するためのアプローチを紹介します。

1.「ご意見ありがとうございます」

- 影響のタイミング:なし

- 範囲:なし

2.「ありがとうございます! あなたのフィードバックにより、今後のランニングのレコメンドが改善されます」

- 影響のタイミング:広く「未来」

- 範囲:すべてのユーザーの「レコメンド」

3.「ありがとうございます! 今後のランニングのレコメンドを改善します」

- 影響のタイミング:広く「未来」

- 範囲:あなたの「レコメンド」

4.「ありがとうございます! 次回のレコメンドには丘は含まれません」

- 影響のタイミング:「次」。決まった習慣がないと、これは少しあいまいです。

- 範囲:「丘」カテゴリー

5.「ありがとうございます。レコメンドが更新されました。見てください」

- 影響のタイミング:「更新されました」というのは即時を意味します。

- 範囲:更新されたコンテンツを実際にやってみたとき。

AIの改善への期待値を設定する

多くのシステムでは、ユーザーからのフィードバックがあっても、AIの出力の多くは以前と変わらないことがあります。ユーザーがより多くのフィードバックをするにつれて、ひとつひとつのフィードバックがAIモデルに与える影響は少なくなります。また、モデルにした改良がわずかすぎて、ユーザーがすぐにはフィードバックできないこともあるでしょう。

フィードバックが、AIモデルの改善にまったく関係していないこともあります。たとえば、プロダクトは、レコメンドの一部として「もっと見る/もっと少なくする」というフィードバックボタンを含むことがありますが、そのフィードバックはAIモデルのチューニングには使われないでしょう。たんに表示されるコンテンツに対するフィルタであり、将来のレコメンドには影響しません。このようなときに、ユーザーが即座にチューニングされるというメンタルモデルを持っていると、ミスマッチな期待になり、ユーザーは混乱し、失望し、不満に感じるでしょう。

このような状況を回避するには、上記のメッセージの例を使って、フィードバックの範囲と影響するまでの時間を明らかにします。モデルがユーザーのニーズに合うようになるまでの時間がユーザーにわかっていれば、ユーザーエクスペリエンスは良くなります。

最良のデータとフィードバックがあっても、AIモデルの改善をすぐにすることはほとんど不可能です。エンジニアリングチームは、個人からのさらなる情報や、グループからの追加データや、あるいはバージョンアップまで、モデルの更新を待たなければならないかもしれません。

こういった遅れが実状であるということは、モデルのパフォーマンスの向上や、AIプロダクトからのより関連のある出力を、ユーザーはいつ期待すればよいのか、明確な期待値を設定しておく必要があるということです。明確なデザインとメッセージで、それをすることができます。

キーコンセプト

ユーザーからのフィードバックを求めるときには、ユーザーにとって、AIの体験がいつどのように改善するのかを考えてください。それぞれのフィードバックのリクエストについて、以下の質問を自分自身にしてください。

- すべてのユーザーグループが、このフィードバックから恩恵を受けますか?

- ユーザーのAIへのコントロールの度合いは、フィードバックをしようという意欲にどのように影響するでしょうか?

- このフィードバックにもとづいてAIはどのように変更されますか?

- このフィードバックにもとづいてAIはいつ変更されますか?

この項の考え方で、ワークシートの演習2をやってみましょう。

➂ コントロールと自動化のバランスをとる。

AIプロダクトにおいて、自動化とユーザーコントロールのあいだに本質的なバランスがあります。プロダクトは、いつでも、すべてのユーザーにとって完璧というわけにはいかないので、ユーザーがニーズに合わせて、出力を調整したり、編集したり、オフにしたりできるようにします。現実の世界におけるユーザーのコンテキストと、ユーザーの手元にあるタスクとユーザーの関係性は、ユーザーがプロダクトをどのように使うかを決めます。タスクを「自動化」するか、プロセスを「拡張」するかどうかについては、「ユーザーニーズ + 成功の定義」の章で詳しく説明しています。

人々がコントロールをいつ維持したいのか理解する

AIプロダクトをつくるとき、もっとも価値のあるプロダクトは、人々が現在は手作業でしているタスクを自動化するものだと思いがちです。これは、現在は完了するのに7つのステップが必要なものを、1つのコマンドでできるようにするようなプロセスでしょう。たとえば、テーマソングコレクションを生成できる音楽アプリを想像してみてください。それがあれば、ユーザーは、アーティストのレビューをし、トラックを聴き、収録すべき曲を決め、そしてソングリストを編集するという時間をかける必要はありません。

このようなプロダクトによるユーザーの利益は明らかに思えるかもしれませんが、しかし、このようなプロダクトをつくるチームは、往々にして、ユーザーが自動化とコントロールについてどのように感じるか、貴重な教訓を学ぶことでしょう。AIであるかないかにかかわらず、人々がタスクやプロセスのコントロールを維持することを望む状況もあります。タスクを「自動化」するのか、プロセスを「拡張」するのかについては、「ユーザーニーズ + 成功の定義」の章で詳しく説明しているので、ここではかんたんに説明します。

人々が仕事を楽しんでいるとき

あらゆるタスクが面倒なわけではありません。何かを楽しんでいるのなら、プロセスのすべてを自動化したいとは思わないでしょう。

人々が結果に対して個人の責任を感じているとき

ほとんどの小さな親切や、個人的なやりとりでは、人々は自らがおかれた社会的義務を果たす責任を負い、コントロールを維持することを望みます。

状況の利害が大きいとき

人々は通常、安全や健康などの身体的な利害、感情を表現することのような感情的な利害、銀行情報を共有することのような金銭的な利害に対しては、責任を持ち続けることを望みます。

特定の好みが伝えられないとき

人々が創造的なビジョンを持っている状況では、多くの人々は主導権を持ち続けようとし、計画を達成することができるようにコントロールを維持しようとします。

人々がいつコントロールを放棄するか理解する

人々がコントロールを放棄しても完全にかまわないと感じ、AIや自動化されたシステムの助けを好むときも、もちろんたくさんあります。

タスクができないとき

やりかたを知っていたり、時間があるときならば、人々はタスクをしますが、できないこともあります。この制限は一時的なものです。

タスクが不快だったり危険だったりするとき

ほとんどの人は、わずかな楽しみや利益を得るために多大な努力やリスクを必要とするタスクを避けるためなら、コントロールを放棄するでしょう。

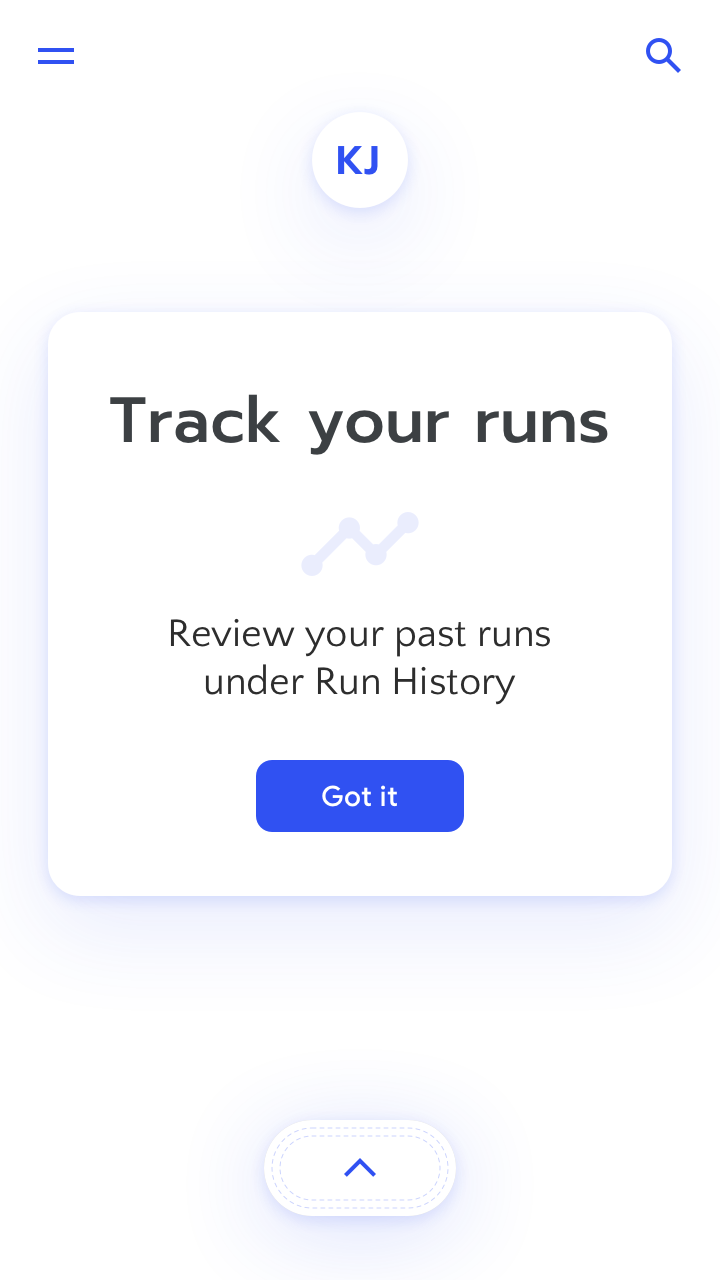

オプトアウトをできるようにする

はじめてAIを紹介するときは、ユーザーがAIを試せるようにするか、AIを無効にすることができるように検討してください。AIのメリットを明確に説明したあとは、その機能を使わないというユーザーの意志を尊重してください。ユーザーはあとでAIを使うことにしたのかもしれません。

プロダクトが、人間のできるタスクとプロセスを拡張するには、人々は、状況に応じて何をするかをコントロールできる必要があります。そのひとつの方法は、ユーザーがタスクを、ふだんの自動ではないやりかたで、できるようにすることです。「メンタルモデル」の章で述べたように、手動による方法は安全で有用な代替方法です。エラーや失敗はAIを改善するのに不可欠なものなので、ユーザーは間違いなく手動によるフェイルセーフを必要とするでしょう。プロダクトの使いはじめはなおのことです。

ユーザーの日常生活における、プロダクトの相対的な優先順位に留意してください。プロダクトを使う人々は、おそらくマルチタスクで、他のプロダクトやアプリも使っていて、概していろいろな方向に注意が引っ張られています。たとえば、ナビゲーションアプリが、ユーザーが運転しているときに、より速い代替ルートをレコメンドすれば、より早く帰宅することができるでしょうが、ユーザーの意識が乗客と交通状況とに散らばっているときは、使うのは危険でしょう。プロダクトはおそらくユーザーの生活の焦点ではないので、エンゲージメントを求めることは戦略的に、最小限に、そしてかんたんに却下できるようにすることを忘れないでください。

編集できるようにする

ユーザーの設定は時間とともに変化する可能性があるため、ユーザーが機械学習モデルのどの設定をコントロールできるようにするか検討し、それを調整できるようにします。これまでシステムのレコメンドや予測に関連性がなかったとしても、将来的には関連性が増すかもしれません。プロダクトは、これまでにした選択を消去したり、更新したり、機械学習モデルをデフォルトのパーソナライズされていない状態へとリセットしたりできるようにするべきです。

キーコンセプト

特定のタスクやプロセスをコントロールしたいという、ユーザーの期待について考える時間をとってください。フィードバックとコントロールのメカニズムを設定するための、かんたんなチェックリストを次に示します。

- AIは、広い範囲のユーザーの能力と好みに対応できますか?

- AIは、健康、富、人間関係など、非常に機微な領域をあつかいますか?

- AIは、目標としている水準の正確さと有用性になるまでに長い時間がかかりそうでしょうか?

- AIは、新たなメンタルモデルが必要となるような、利害の大きい状況で使われますか?

- モデルの「リセット」や「引き継ぎ」が必要となるような、ユーザーのニーズの変化はありますか?

この項の考え方で、ワークシートの演習3をやってみましょう。

まとめ

AIによる機能やプロダクトをつくるときには、フィードバックとユーザーのコントロールが、ユーザーとシステムのあいだのコミュニケーションと信頼感を築くために、そしてユーザーのニーズを長期にわたって満たすプロダクトを開発するために不可欠です。フィードバックのメカニズムは、「メンタルモデル」、「説明 + 信頼感」、そしてAIのチューニング方法と密接に連携しています。これら3つの側面は、ユーザーにとってプロダクトを改善するうえでの鍵となります。

AIを使うとき、フィードバックとコントロールのメカニズムについて、新しく考えるべき点が3つあります。

➀ フィードバックをモデルの改善に合わせる。「暗黙的な」フィードバックと「明示的な」フィードバックの差を明確にし、適切な粒度の適切な質問をする。

➁ 影響を与える価値と時期を伝える。なぜ人々がフィードバックをするのかを理解し、メリットを説明し、フィードバックがユーザーの体験をいつどのように変えるのかを伝えて、メンタルモデルを構築する。

➂ コントロールと自動化のバランスをとる。ユーザーが求めるエクスペリエンスの側面をコントロールできるようにするとともに、フィードバックすることをかんたんにオプトアウトできるようにする。

議論を円滑にし、イテレーションをスピードアップし、落とし穴を避けたいですか? ワークシートを使用してください。

- Baxter, K. (2017, April 12). How to Meet User Expectations for Artificial Intelligence

- Clapper, G. (2018, October 4). Control and Simplicity in the Age of AI

- Culotta, A., Kristjansson, T., Mccallum, A., & Viola, P. (2006). Corrective feedback and persistent learning for information extraction. Artificial Intelligence,170(14-15), 1101-1122.

- Dietvorst, B. J., Simmons, J. P., & Massey, C. (2015). Overcoming Algorithm Aversion: People Will Use Algorithms If They Can (Even Slightly) Modify Them. SSRN Electronic Journal.

- Harley, A. (2018, September 30). Individualized Recommendations: Users’ Expectations & Assumptions

- Harley, A. (2018, November 4). UX Guidelines for Recommended Content

- Jugovac, M., & Jannach, D. (2017). Interacting with Recommenders—Overview and Research Directions. ACM Transactions on Interactive Intelligent Systems,7(3), 1-46.

- Parasuraman, R., & Riley, V. (1997). Humans and Automation: Use, Misuse, Disuse, Abuse. Human Factors: The Journal of Human Factors and Ergonomics Society.

- Parra, Denis & Amatriain, Xavier. (2011). Walk the Talk - Analyzing the Relation between Implicit and Explicit Feedback for Preference Elicitation.. Nursing standard (Royal College of Nursing (Great Britain) :1987). 14. 255-268.

- Stumpf, S., Rajaram, V., Li, L., Burnett, M., Dietterich, T., Sullivan, E., … Herlocker, J. (2007). Toward harnessing user feedback for machine learning. Proceedings of the 12th International Conference on Intelligent User Interfaces - IUI 07.

- Szaszko, M. (2017, September 27). UX design for implicit and explicit feedback in an AI product

- Thomaz, A. L., Hoffman, G., & Breazeal, C. (2006). Experiments in socially guided machine learning. Proceeding of the 1st ACM SIGCHI/SIGART Conference on Human-robot Interaction - HRI 06.

- Virtue, E. (2017, September 26). Designing with AI