エラー + 上手な失敗

AIがエラーを起こしたり失敗したりすると、事態は複雑になります。この章の内容は次のとおりです。

- ユーザーが、確信度の低い予測を「エラー」と見なすのはいつですか?

- 複雑なAIのエラーの原因をどのようにすれば確実に特定できるでしょうか?

- AIが失敗したとき、ユーザーが先に進めるようになっていますか?

議論を円滑にし、イテレーションをスピードアップし、落とし穴を避けたいですか? ワークシートを使用してください。

AIを使うときに新しいこと

ユーザーがプロダクトとインタラクションするとき、ユーザーは、開発プロセスでは予想だにしない方法を試みるでしょう。誤解や、フライングスタートや、不測の事態が起こります。このようなケースの設計は、あらゆる人間中心のプロダクトの中核的な要素です。エラーもチャンスです。試せるようにすることで素早い学習をサポートし、正しいメンタルモデルを形成し、ユーザーにフィードバックをするように促します。

「Nielsen Norman Group の Error Messaging Guidelines」のような、エラーを伝えるときの優れたガイドがあり、それはAIの機能やプロダクトをつくるときにも、依然として当てはまります。

AIシステムでのエラー処理について、主に考えるべきことは次です。

➀ 「エラー」と「失敗」を定義する。ユーザーがエラーとみなすものは、AIシステムへの期待値と深く関連しています。たとえば、60%の確率で役に立つレコメンドシステムは、ユーザーとシステムの目的により、失敗とも成功ともみなすことができます。これらのインタラクションがどのように処理されるかにより、メンタルモデルが形成されたり修正されたりし、ユーザーの信頼感が調整されます。

➁ エラーの原因を特定する。AIシステムでは、エラーはさまざまな場所から発生し、特定しにくくなり、直感的ではないかたちでユーザーやシステム開発者に表示されます。

➂ 失敗しても先に進めるようにする。AIの能力は時間とともに変化します。発生したエラーに応じてユーザーが行動できる道を用意することで、システムへの忍耐力が高まり、ユーザーとAIの関係性が維持され、全体的なエクスペリエンスが向上します。

➀ 「エラー」と「失敗」を定義する。

AIをプロダクトへ組み込むことは、ユーザーとAIシステムがインタラクションするにつれて変化していく関係性をつくることです。ユーザーは、インタラクションが自分の趣味や行動によって決まること、そして体験はユーザーによって異なることを、期待するようになるでしょう。

したがって、エラーの定義は、ユーザーの専門知識や、ゴールや、「メンタルモデル」や、プロダクトを使った過去の体験により、ユーザーごとに異なってくるでしょう。

たとえば、AIによる音楽レコメンドシステムが、「お気に入り」に入っている曲だけを使ってレコメンドすると、ユーザーが想定しているとき、システムがお気に入りリスト外のジャンルをレコメンドしたら、ユーザーはエラーと考えるかもしれません。レコメンドが広範囲の要素にもとづいていると考える人は、これを誤りとは考えないかもしれません。「メンタルモデル」の章に、システムの機能、限界、そしてインタラクションモデルについて、ユーザーに理解を深めてもらうための詳細があります。

ユーザーエラー、システムエラー、コンテキストエラーを特定する

AIではないシステムでは、「ユーザーエラー」は通常、システム設計者の観点から定義され、ユーザーの「誤用」のせいでエラーが発生したと非難されます。一方、「システムエラー」は通常、ユーザーの観点から定義されます。ユーザーはプロダクトの柔軟性が足りないため自分のニーズが満たされないとして、システム設計者を責めます。AIシステムでは、ユーザーについてのシステムの予測にもとづく、3番目のタイプのエラーがあります。それは「コンテキストエラー」です。

コンテキストエラーは、ユーザーが特定の時間や場所で何をしたいのかを、AIシステムが誤って推定することによって、その有用性が下がることです。その結果、ユーザーが混乱したり、タスクが失敗したり、プロダクトをまったく 放棄したりすることがあります。コンテキストは、個々人のライフスタイルや好みに関連し、パターンは、より広い文化的価値につながっています。

たとえば、レシピのレコメンドアプリを使っている人が、夕方にレコメンドを頻繁に拒否する場合、このパターンはプロダクトチームに、そこに持続的な理由があることを知らせるものです。ユーザーが夜勤をしているのであれば、仕事に行く前に、シンプルに朝食のレコメンドを好むかもしれません。特定のグループのすべてのユーザーが、特定の期間に、一斉に肉料理のレコメンドを拒否した場合、それはチームが知らない文化的価値や好みに関連している可能性があります。

コンテキストエラーを防止したり修正したりするには、AIがユーザーのコンテキストを推測するために使っているシグナルを調べて、ユーザーのコンテキストの推測が誤っていたり、見落としていたり、過小評価していたり、過大評価したりしていないか、調べます。

コンテキストエラーやその他のエラーは、ユーザーの期待値とシステムの予測とのあいだのインタラクションである、と考えることができます。以下は、どのようにしてユーザーの期待値とシステムの予測のインタラクションがエラーを引き起こすかの、具体的な内容です。

ユーザーが認識したエラーを分類する

コンテキストエラー。これは往々にして「真陽性」のケースです。システムは「意図したとおりに動いている」が、ユーザーはエラーだと認識しています。それは、システムの動作が十分に説明されていなかったり、ユーザーのメンタルモデルを壊していたり、予測の精度が悪いためです。たとえば、友人のフライトを知らせるメールでカレンダーに予定が登録されても、あなたはそれを望んでいなかったり、必要としていなかったりするときです。

コンテキストエラーへの対処は、その頻度と重大度によります。システムの機能を変更して、ユーザーのニーズや期待値に沿うように調整することもあるでしょう。または、プロダクトのオンボーディングを調整して、より適切なメンタルモデルを形成し、この状況についてのユーザーの認識をエラーから予想した動作へと変更します。

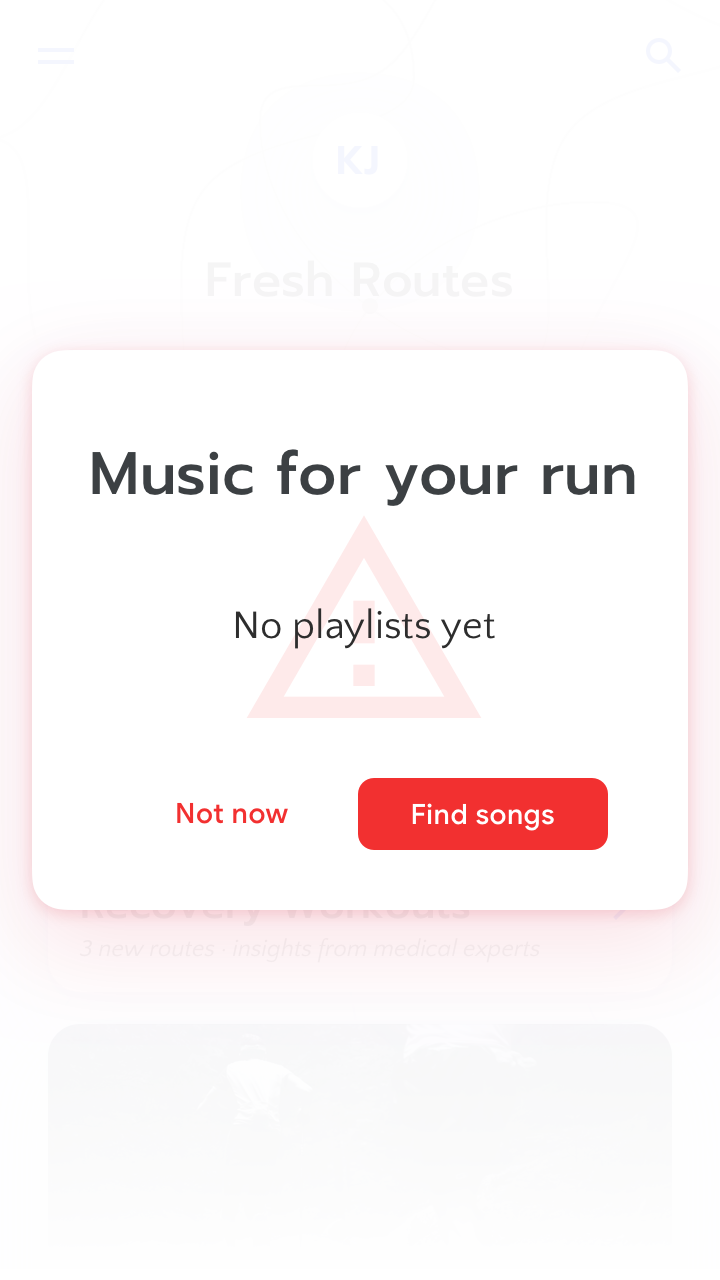

失敗。システムは正しく答えることができないか、システムの限界のためにまったく答えることができません。これは「真陰性」のケースでしょう。機械学習にとっては、与えられたインプットに対して出せるアウトプットがないということもあり得るのですが、ユーザーにとってはそうではないのです。たとえば、画像認識アプリでさまざまな種類の動物を識別できても、トレーニングデータセットに含まれていない動物の写真をユーザーが示して、それが認識できないと、それはやはり誤りなのです。

ユーザーが認識するエラーメッセージでは、システムの制限について、できるだけ具体的にユーザーに知らせるようにします。

ユーザーが認識していないエラーの原因をつきとめる

これらのエラーはユーザーには見えないので、ユーザーインターフェイスで説明する方法を心配することはありませんが、知っておくとAIの向上に役立ちます。

幸福なアクシデント。システムは、低い確信度の予測や、制限や、エラーであるとフラグを立てますが、まれに役に立ったり興味深かったりすることがあります。たとえば、ユーザーが、それが不可能であると知っていながら冗談でスマートスピーカーにゴミを捨てるように指示し、ユーザーとその家族はスピーカーの反応に面白がっています。

バックグラウンドのエラー。システムは正常に動作していないが、ユーザーもシステムもエラーだとしていない状況。たとえば、検索エンジンが誤った結果を返し、ユーザーがそのように認識していない場合です。

これらのタイプのエラーは、長期間見つからなければ重大な結果をもたらすことがあります。またこれらのエラーは、システムの失敗率とエラー率をどのように測定するかについても重要な意味を持ちます。ユーザーのフィードバックからこれらのエラーを検出することはほとんどないため、システムのストレステストをして、「知られていない知らないこと」を見つけるために特化した品質保証プロセスが必要になるでしょう。

ユーザージャーニーにおけるタイミングを説明する

ユーザーは、プロダクトを使いはじめたときと、その後のプロダクトが何をできて何をできないかの期待値がしっかりしたときでは、発生したエラーへの反応が異なるでしょう。ユーザーがプロダクトを使用してからの経過時間は、AIがユーザーにどのようにエラーを伝達するかに影響を与え、ユーザーが軌道に乗るのに役立ちます。

たとえば、ユーザーが音楽レコメンドシステムとはじめてインタラクションするときに、最初のレコメンデーションが自分に関係がなくても、エラーとはみなさないでしょう。ただし、1年のあいだ聴き続けて、いいねをし、お気に入りをプレイリストに追加した後は、ユーザーはシステムのレコメンドの関連性に高い期待を抱いているので、不適切なレコメンドをエラーとみなします。

状況による利害とエラーのリスクを量る

状況によっては、AIのエラーや失敗は不便で済みますが、ときには深刻な結果につながることがあります。たとえば、AIのレコメンドによる電子メール自動返信のエラーは、自動運転車のエラーとは、大きく異なる利害を抱えています。AIでないシステムにも当てはまりますが、AIシステムの複雑さとコンテキストエラーの可能性のため、AIが意思決定をする状況の利害には、とくに注意を払う必要があります。

あらゆるシナリオには固有の利害がありますが、エラーのリスクは、他のコンテキストの要因によっても変わることがあります。たとえば、ユーザーがAIプロダクトを使っているときに、マルチタスクをしていたり、時間に焦っているとき、システムの出力をダブルチェックするための心理的な余裕は少なくなります。

潜在的なエラーのリスクを評価する

低い

- ユーザーはそのタスクの専門知識を持っている。

- システムの確信度が非常に高い。

- 成功する可能性が高い。

高い

- ユーザーはそのタスクの初心者である。

- 注意力や反応時間が短縮されている。(マルチタスク)

- システムの確信度が低い。

- 成功の条件が狭い。

状況の利害を評価する

低い

- お試しのとき。

- 遊びやクリエイティブのとき。

- 軽いエンターテイメントのとき。

- レコメンドが必須ではないとき。

高い

- 健康、安全、または金銭上の意思決定のとき。

- 社会的なコンテキストが機微なとき。

さまざまな状況において、どのようなシステム応答、ユーザー応答、メッセージが必要かを検討するときは、「ユーザーニーズ + 成功の定義」の章の、「報酬関数」の設計についてのセクションを参照してください。「説明 + 信頼感」の章で説明されている、利害が大きいシナリオと、対応する必要な説明方法も参照してください。

キーコンセプト

システムがエラーにどのように対応するかを設計する前に、ユーザーがすでに認識しているエラーや、発生する可能性があるエラーを特定してください。それらを次のカテゴリに分類します。

- システムの限界。システムの限界があるため、システムは正しく答えられないか、まったく答えられません。

- コンテキスト。システムは「意図したとおりに動いている」が、ユーザーはエラーだと認識しています。それは、システムの動作が十分に説明されていなかったり、ユーザーのメンタルモデルを壊していたり、精度の悪い予測にもとづいているためです。

また、バックグラウンドのエラーについても気にしてください。システムが正常に動作していないが、ユーザーもシステムもエラーだとしていない状況のことです。

上記のそれぞれの状況について、次のように自分自身に尋ねてみてください。

- このエラーはユーザーにどのように影響しますか?

- この状況において、ユーザーにとって利害は大きいでしょうか小さいでしょうか?

この項の考え方で、ワークシートの演習1をやってみましょう。

➁ エラーの原因を特定する。

「ユーザーニーズ + 成功の定義」の章では、AIが出力を最適化するための「報酬関数」の設計と評価する方法について説明しています。システムで発生しうるエラーの範囲と種類は、この報酬関数によって異なりますが、ただし一般的に言って、AIに固有のエラーの原因はいくつかあります。

予測とトレーニングデータのエラーを見つける

これらのエラーは、「トレーニングデータ」の問題や、機械学習モデルの「チューニング」方法に起因しています。たとえば、ナビゲーションアプリに、特定の地域の道路についてのトレーニングデータがなければ、その機能が制限されることでしょう。

ラベルがなかったり、誤ってラベルづけがされた結果

トレーニングデータが不十分であるために、システムからの出力に誤ったラベルがつけられていたり、誤って分類されていることがあります。たとえば、植物分類アプリのトレーニングデータで、ベリーに矛盾のあるラベルづけがされていたら、ストロベリーをラズベリーとして誤分類することにつながるでしょう。

対応:ユーザーが、データやラベルを手引きしたり修正したりできるようにします。これはデータセットを改善するためにモデルにフィードバックしたり、追加のトレーニングデータの必要性をチームに知らせたりします。

不十分な推論や誤ったモデル

十分なトレーニングデータがあるにもかかわらず、機械学習モデルが十分に「的確」ではないことがあります。たとえば、植物分類アプリには、ベリーを含め、しっかりとラベルづけされたデータセットがありますが、モデルのチューニングが不十分であると、ストロベリーを識別しようとしたとき、多数の偽陽性が返されます。

対応:ユーザーが、データやラベルを手引きしたり修正したりできるようにします。これはモデルにフィードバックされ、チューニングに役立ちます。

欠落したり、不完全なデータ

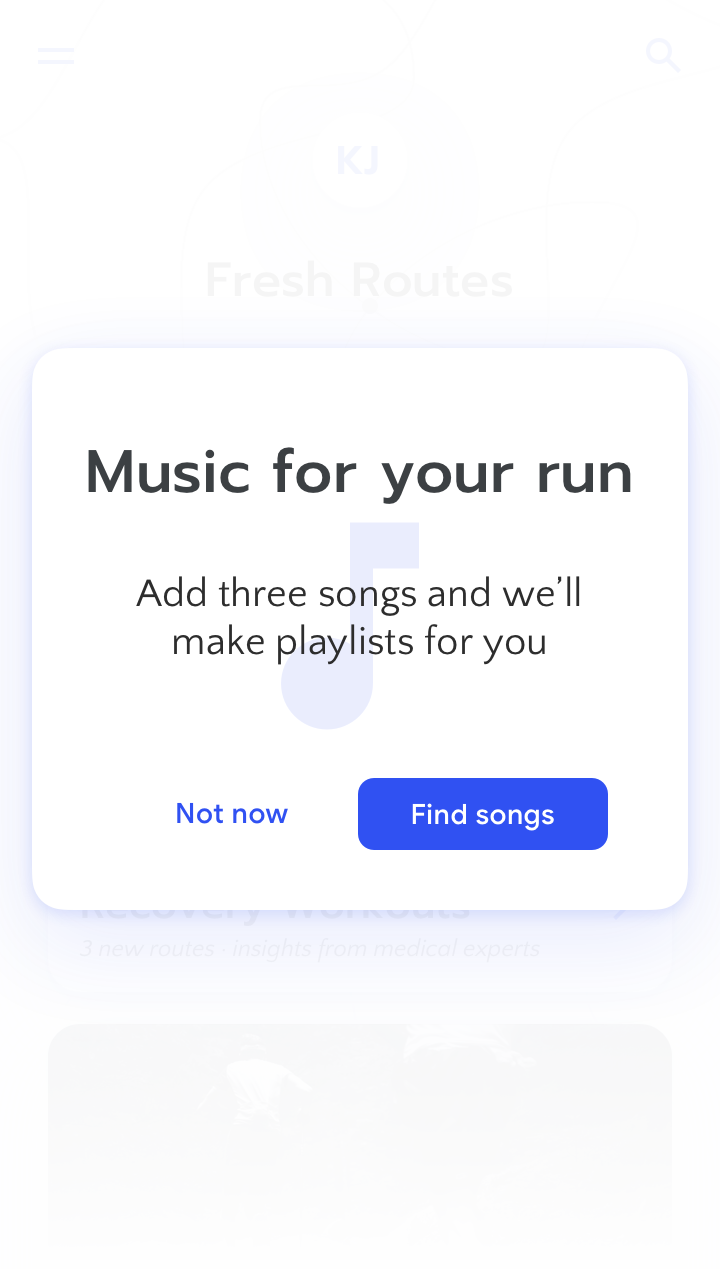

ユーザーが、トレーニングデータによりモデルができることの限界に達したとき。たとえば、ユーザーが植物分類アプリで、犬の分類をしようとしたときです。

対応:システムが何をすることになっているのか、どのように動くのか伝えてください。それから、システムに何が欠けているのか、何の制限があるのかを説明してください。システムが満たしていないニーズについては、ユーザーがフィードバックできるようにします。

正しいデータソースを見つける方法と、その説明方法については、「データ収集 + 評価」と「説明 + 信頼感」の章を参照してください。

入力エラーを予測や計画しておく

このエラーは、AIが実際にそれができるかどうかにかかわらず、ユーザーの入力が何を意味するのかをシステムが「理解してくれる」という、ユーザーの期待値から来ています。

予期しない入力

ユーザーが、AIシステムへの入力の自動補正を期待しているとき。たとえば、ユーザはタイプミスをし、それでもシステムがユーザーの意図したつづりを認識してくれることを期待しているときです。

対応:ユーザーの入力と、さまざまな「可能性のある」回答とを比較して、その入力を意図しているかどうかを確認します。たとえば、「XYZを検索するつもりでしたか?」というようにします。

慣れを妨げる

ユーザーがシステムのUIのインタラクションに慣れていたが、システムの変更がされたことで、ユーザーの行動が異なる、望ましくない、結果につながるとき。

たとえば、あるファイルストレージシステムでは、ユーザーはつねにインターフェイスの右上の領域をクリックしてフォルダーにアクセスしていましたが、新しく実装されたAIによる動的なデザインにより、フォルダーの場所は頻繁に変わるようになりました。体が覚えている動作でその領域をクリックすると、間違ったフォルダが開くようになりました。

対応:予測がしづらいAIの出力で、インタフェースの特定の領域を指定するような、慣れを妨げる方法でAIを実装しないでください。または、ユーザーが特定のインタラクションパターンへ戻ったり、選択したり、再トレーニングできるようにします。Google Design blog の慣れについてのこの記事(訳注:原文にリンク無し)に、より多くの解決方法があります。

誤って調整された入力

システムが、行動や選択を不適切に重みづけするとき。たとえば、音楽アプリでアーティストを検索したら、そのアーティストの音楽が延々とレコメンドされるようになってしまうようなとき。

対応:システムが入力と出力をどのように一致させているかを説明し、ユーザーがフィードバックによりシステムを修正できるようにしてください。

関連性のエラーについて出力の品質をチェックする

AIシステムが、つねに適切な情報を、適切なタイミングで提供できるとは限りません。無関係な出力は、多くの場合、「コンテキストエラー」の原因となります。つまり、意図したとおりに動作しているシステムと、ユーザーの現実のニーズとの衝突です。ユーザー入力のエラーやデータエラーとは異なり、これは情報の正確性やシステムが意思決定をどのようにしたかには問題ありません。このエラーは、システムの結果がいつどのように配信されたか、あるいはされなかったかの問題です。

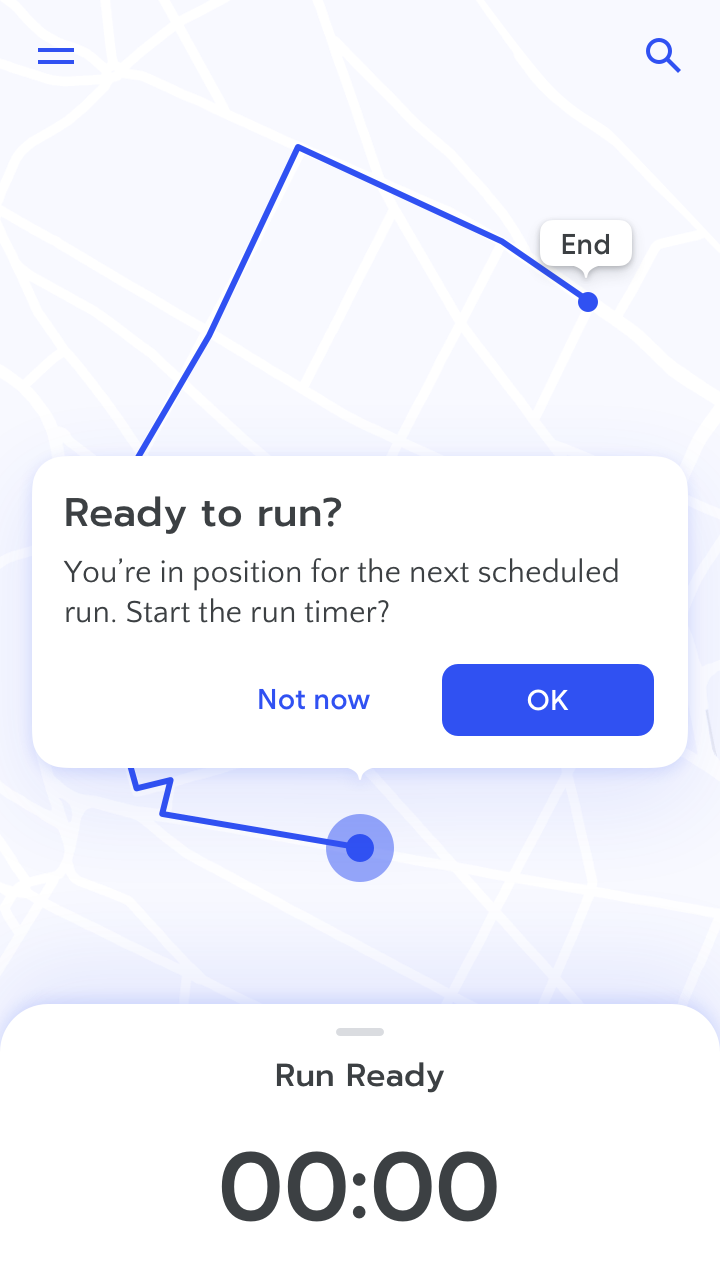

低い確信度

不確実性の制約のために、モデルが与えられたタスクをできないときです。利用可能なデータの欠如や、予測精度の要件や、変動する情報などです。たとえば、フライト価格の予測アルゴリズムでは、状況が変化するので、来年の価格を正確に予測できないことがあります。

対応:なぜ結果を得られなかったのかを説明し、代替方法を提案する。たとえば、「来年のパリへのフライト価格を予測するのに十分なデータがありません。1か月後にもう一度確認してください」とします。

無関係

システム出力の確信度は高いが、ユーザーのニーズに関係のないかたちでユーザーに表示されるとき。たとえば、ユーザーが家族の葬儀のためにヒューストンへの旅行を予約しているが、旅行アプリは「休暇の行楽」をレコメンドしているようなとき。

対応:システムの機能を向上させるために、ユーザーがフィードバックできるようにしてください。

システムの階層的なエラーを明らかにする

このエラーは、うまく同期していない複数のAIシステムを使うことで発生します。これらの重なり合いは、状況のコンロールやユーザーの注意をめぐって衝突する可能性があります。AIシステムが、他のシステムとどのようにインタラクションするかを事前に計画し、出力を管理して衝突を回避するための複数のレベルの権限を、ユーザーに提供します。

複数のシステム

ユーザーがプロダクトを別のシステムにつないだとき、どの時点でどのシステムが担っているのか、明らかではないときです。

たとえば、ユーザーは「スマートエアコン」を「スマートエネルギーメーター」につなぎますが、2つのシステムではエネルギー効率を最適化する方法が異なります。システムは互いに矛盾する信号を送り合い、正しく機能しなくなります。

対応:つないでいる複数のシステムについて説明し、ユーザーが優先順位を決められるようにします。それらを異なる位置づけできるような、プロダクトインターフェースにおける複数のAIシステムの関係を、視覚的に表現する方法を検討してください。

信号の衝突

複数のシステムが単一の(または類似の)出力を監視しており、イベントが発生すると同時にアラートも発生します。

信号の衝突は、ユーザーの精神的負荷を増大させます。何が起きたのか、そして何をしなければならないのかを把握するために、ユーザーは複数の情報ソースを解析しなければならないためです。

たとえば、ユーザーの音声入力が、複数の音声起動システムに認識され、それらが同時に異なる方法で応答したとします。ユーザーはそれに打ちのめされ、次に何をすべきかわからないでしょう。

対応:他の信号と重ならないように、ユーザーがAIに対して独立したコントロールを設定できるようにしてください。たとえば、スマートスピーカーがリスニングをはじめるためのウェイクワードは固有のものです。新しいコンテキストエラーの発生を避けるために、ユーザーはどのシステムが前面に出ていることを意図しているのか、システムに推論させることもできるでしょう。

キーコンセプト

エラーごとに、結果となるユーザーエクスペリエンスにもとづいて、原因を特定します。以下の例にもとづいて、どのようなエラーがあるのかを確認してください。

予測とトレーニングデータのエラー:システムの能力が、そのトレーニングデータによって限界があるときに発生します。

入力エラー:ユーザーが、AIシステムへの入力の自動修正を期待しているときや、ユーザーの慣れが妨げられているときに発生します。

関連性のエラー:ユーザーのニーズに関係のない時間、場所、形式で、システムの出力が表示されたときに発生します。

システムの階層的なエラー:ユーザーがプロダクトを別のシステムにつないだ場合に、どのシステムが担っているのか明らかでないときに発生します。

この項の考え方で、ワークシートの演習2をやってみましょう。

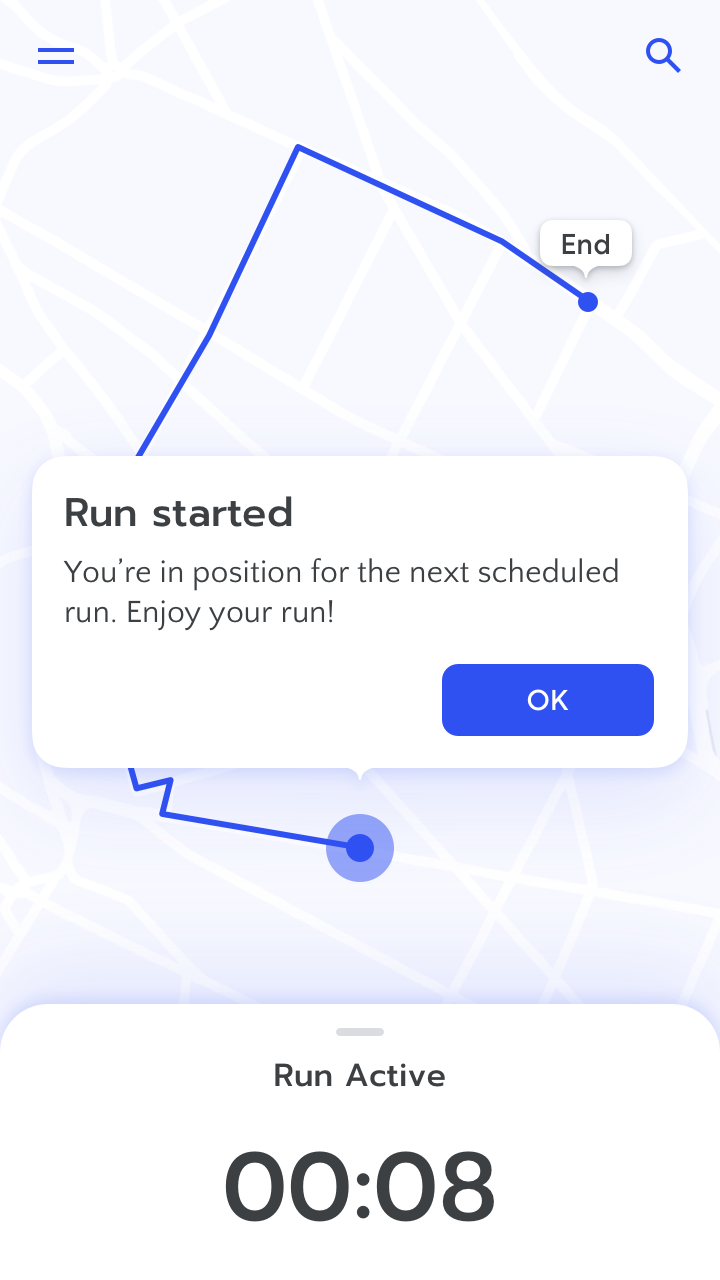

➂ 失敗しても先に進めるようにする。

テクノロジーの限界について、合理的な期待値を設定することは、エラーにおける良い体験をつくるのにつながります。しかし同じように重要なことは、ユーザーがどのようにして先に進めるかです。システムが失敗したときにユーザーが何をできるかに焦点を合わせることで、プロダクトの有用性を維持することができます。

これまでは、レストランのウェイターは、顧客がメニューにある何かを望んでいても、キッチンでは切らしてしまっているときには、顧客の暗黙の好みを考慮に入れて、別の選択肢を出すことができました。たとえば、「コカ・コーラを切らしておりまして、ペプシでもよろしいでしょうか?」というようにです。より利害の大きい状況のときは、代替案が本当に安全な選択肢であることを確かめるために、ダブルチェックをするべきです。たとえば、ユーザーがレストランにはない料理を希望していて、しかし、それにもっとも近い料理に一般的なアレルゲンが含まれていたら、ウェイターはその代案を提示する前にダブルチェックしたいと思うでしょう。このような失敗における主なゴールは、ユーザーへの過度の害を防ぎ、ユーザーがタスクを先に進めていけるようにすることです。

フィードバックの機会をつくる

上記のセクションで強調したように、ユーザーが体験するエラーの多くは、システムを改善するためにユーザーのフィードバックを必要とします。とくに、ラベルが誤っているデータのような、システム自体ではなかなか認識できない種類のエラーは、その修正は外部からのフィードバックに依存します。

エラーメッセージが表示されたときだけでなく、「正しい」システム出力が表示されたときにも、ユーザーにフィードバックをする機会をつくります。たとえば、システムが失敗したときには、何があるとよいかをユーザーに尋ね、不適切なレコメンドを報告するための選択肢を提示します。

ユーザーにコントロールを戻す

AIシステムが失敗したとき、もっともかんたんな方法は、多くの場合、ユーザーに引き継ぐことです。ユーザーに完全な 「上書き」権限を付与できるかどうか、そしてそれがそのように見えるかどうかは、システムによって異なります。状況によっては、手動に戻すのは、リスクがあったり危険だったりします。たとえば、ラッシュアワーの交通渋滞で、なじみのない環境を運転しているユーザーに、ナビゲーションシステムがまったく指示をしなくなったときです。

このようなAIから手動へのコントロールの移譲が起きたときには、システムが中断したところから、ユーザーがかんたんで直感的に、すばやく再開できるようにすることが、プロダクトの責任になります。つまり、ユーザーは操作するために必要なすべての情報を持っている必要があります。状況の認識、次にすべきことは何か、そしてそれをどうやるのか、です。

悪意ある使用を想定する

有益で実用的なエラーメッセージを書くことは重要ですが、意図的にそれを悪用しようとする人々もいることを念頭にプロダクトを設計するべきです。つまり、「ユーザーニーズ + 成功の定義」の章にあるような、プロダクトの潜在的な悪影響を特定することに加えて、失敗を、安全に、退屈に、プロダクトのなかで自然になるようにしてください。危険な失敗を面白くしたり、システムの脆弱性を過度に説明したりはしないでください。そのようなことをすると、ユーザーが失敗を再現しようとすることがあります。

たとえば、ユーザーが受信トレイ内の電子メールをスパムとしてマークするたびに、電子メールアプリがそのメッセージをスパムとして分類しなかった理由を説明したとすると、スパム配信者には、フィルタにつかまらないようにするための有用なヒントを与えることになります。

プロダクトに潜在している行き止まりをすべて明確にするには、ベータテストとパイロットプログラムにコストを遣うようにします。多くのプロダクトは、選択肢と可能性の迷路のようなものです。制作者が理想的なケースだけ見ていると、ユーザーは迷路につかまってしまうでしょう。

キーコンセプト

最初に品質保証テストとパイロット運用をすることで、エラーを見つけることができますが、リリースするあらゆる新機能を網羅するためには、監視を続ける必要があります。チームとして、ユーザーによる新しいエラーの発見を監視するチャネルを決めます。次のエラー報告のソースのうち、どれがチームの役に立つでしょうか?

- カスタマーサービスに送信された報告

- ソーシャルメディアで送信されたコメントと報告

- プロダクト内での評価指標

- プロダクト内でのアンケート

- ユーザー調査

- プロダクト外でのアンケート

- デプスインタビュー

- 日記法

エラーを見つけたら、エラーから正しい方向へ進める道を用意できるよう、チームとして動く必要があります。

この項の考え方で、ワークシートの演習2をやってみましょう。

まとめ

学習は、機械的なものであってもなくても、間違うことなくして成し得ません。エラーが不可欠であると認識してシステムを設計し構築することは、ユーザーと対話する機会を生み出します。これにより、エラーを解決し、ユーザーが目標を達成するための、より効率的な方法ができます。

エラー体験を設計するときは、機械的にならず、人間的であってください。エラーメッセージは、システムがミスをしたことを開示する必要があるかもしれません。人道的に謙虚にミスに対処し、システムの限界を説明して、ユーザーに前に進んでもらうようにしましょう。

➀ 「エラー」と「失敗」を定義する。「確率的」で動的なシステムにおいて、システムが意図したとおりに機能している状況でも、ユーザーは失敗を認識することがあります。プロダクトが成長過程にあるとユーザーが知ることは、利用を推進したり、デザイナーやエンジニアがAIの改善をするために必要なフィードバックをすることを促進します。

➁ エラーの原因を特定する。AIシステムの固有の複雑さは、エラーの原因を特定することを困難にします。エラーを発見し、その原因を特定する方法について、チームとして話し合うことが重要です。

➂ 失敗しても先に進めるようにする。失敗を避けるのではなく、それを見つけて、プロダクトの他の部分と同じくらい人間中心にすることです。システムがうまく機能するように、あなたがどれだけ苦心しても、AIは本質的に「確率的」であり、あらゆるシステムと同じように、失敗することがあるでしょう。そのようなとき、プロダクトは、ユーザーがタスクを続けることができる方法を提供し、AIの向上に役立つようにします。

議論を円滑にし、イテレーションをスピードアップし、落とし穴を避けたいですか? ワークシートを使用してください。

- Amershi, S., Weld, D., Vorvoreanu, M., Fourney, A., Nushi, B., Collisson, P., … Horvitz, E. Guidelines for Human AI Interaction.CHI 2019

- Baxter, K. (2017, April 12). How to Meet User Expectations for Artificial Intelligence

- Coping with human errors through system design: Implications for ecological interface design. (1990). Applied Ergonomics, 21(4), 337-338.

- Laubheimer, P. (2015, September 7). Preventing User Errors: Avoiding Conscious Mistakes

- Luger, E., & Sellen, A. (2016). “Like Having a Really Bad PA”. Proceedings of the 2016 CHI Conference on Human Factors in Computing Systems - CHI 16.

- Nielsen, J. (2000, January 23). Saying No: How to Handle Missing Features

- Nielsen, J. (2001, June 24). Error Message Guidelines

- O’Meara, T. (2012, July 24). Failing Gracefully. UX Magazine.

- Pearl, C. (2017). Designing voice user interfaces: Principles of conversational experiences. Beijing: OReilly.

- Posniak, M. (2017, November 9). The Art of the Error Message

- Stumpf, S., Rajaram, V., Li, L., Burnett, M., Dietterich, T., Sullivan, E., … Herlocker, J. (2007). Toward harnessing user feedback for machine learning. Proceedings of the 12th International Conference on Intelligent User Interfaces - IUI 07.

- Winter, D. (2018, June 19). AI Errors vs. Human Errors. International Director.